ChatGPT je dobře známý jazykový model poháněný umělou inteligencí, který nemusím představovat. Bezvadně komunikuje česky i v dalších jazycích a může převzít řadu pracovních úkolů. Pokušení jej okamžitě nasadit je veliké, všude jsou nabízeny kurzy nebo výuková videa o tom, jak napsat ten „nejlepší prompt.“ Ačkoliv sám ChatGPT používám, přesto je důležité nezapomínat také na hranice a rizika možného použití ChatGPT a dalších obdobných nástrojů využívajících umělou inteligenci.

Co se děje s vašimi vstupy?

Pod pojmem „vstup“ (Input) se rozumí vše, co napíšete nebo vložíte do komunikačního pole a odešlete jako tzv. prompt. ChatGPT vzápětí vygeneruje odpověď nebo jiný výsledek, tzv. „výstup“ (Output).

A co se tedy s vašimi vstupy děje? Upřímná odpověď zní: vlastně nevíme a nemáme nad tím žádnou kontrolu…

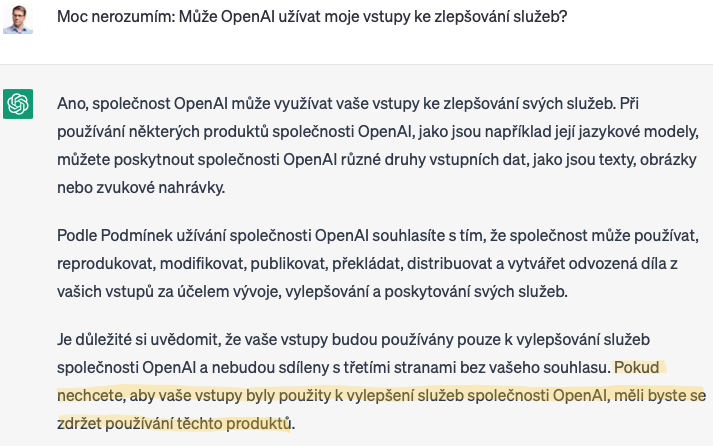

Podle Terms of use, tj. Podmínek užívání společnosti OpenAI L.L.C. (dále „OpenAI“), která je provozovatelem ChatGPT, umožňují použít vaše vstupy „ke zlepšování služeb“. Podobný článek nalezneme také v Privacy policy OpenAI.

Modely založené na machine learning jsou trénovány na obrovském množství dat. A pokud jsou vstupy uživatelů jakkoliv užívány za účelem takového tréninku, nelze vyloučit, že se vaše vstupy objeví u jiného uživatele jako součást výstupu ChatGPT. A to nechcete.

A co nám k tomu řekne ChatGPT? Užívání znamená souhlas s Podmínkami užívání. A na dotaz uvádí: „Pokud nechcete, aby vaše vstupy byly použity k vylepšení služeb společnosti OpenAI, měli byste se zdržet používání těchto produktů“.

Jaké právní následky může mít neřízené užívání ChatGPT?

Možných rizik může být více, navíc se mohou vyskytovat souběžně:

- Porušení obchodního tajemství a povinnosti mlčenlivosti

Každá firma má vlastní obchodní tajemství a obvykle také důvěrné informace třetích osob, ke kterým má povinnost mlčenlivosti, ať už na základě smlouvy (typicky z NDA), nebo v případě některých profesí také ze zákona (např. mlčenlivost advokáta). Jak jsme si ukázali shora, v okamžiku, kdy zadáte jakékoliv informace do ChatGPT, ztrácíte nad nimi kontrolu.

Proto je při užívání ChatGPT důležité dbát na jednu základní zásadu: „Nevkládejte žádná taková citlivá data!“ To zní jednoduše. Ale ne každý zaměstnanec je schopen samostatně něco takového vyhodnotit.

- Porušení povinností při zpracování osobních údajů

- Už samotným vložením osobních údajů třetích osob do ChatGPT dochází k jejich zpracování třetí osobou – OpenAI, aniž by předtím byla uzavřena smlouva o zpracování dle čl. 28 Nařízení GDPR.

- Nevíte, kam jsou osobní údaje ukládány a co se s nimi dále děje (zásada transparentnosti zpracování).

- Nevíte, po jakou dobu budou osobní údaje uloženy a zpracovávány (zásada omezení uložení).

- Je pravděpodobné, že takové nakládání s osobními údaji je v rozporu s původním účelem jejich zpracování (zásada účelového omezení) a že k takovému nakládání nemáte právní důvod (zásada zákonnosti).

- Shora uvedené body představují rovněž porušení zásady integrity a důvěrnosti, protože jste fakticky nezabezpečili vložené osobní údaje v před rizikem neoprávněného zpracování. Podmínky užití OpenAI navíc obsahují vzdání se jakékoliv odpovědnosti za případné škody, které při užívání ChatGPT vzniknou.

- ChatGPT pokaždé přesvědčivě odpoví, i když často ve svých výstupech uvádí nepřesné a zavádějící údaje. Není proto vyloučeno, že zkreslí také osobní údaje, s nimiž pracuje (zásada přesnosti zpracování).

- Servery společnosti OpenAI se nachází pravděpodobně mimo území EU, předávání osobních údajů mimo EU je přitom přísně regulováno a omezováno.

- Jako správci jste povinni doložit, že osobní údaje zpracováváte v souladu s Nařízením GDPR (zásada odpovědnosti). Jakmile osobní údaje třetích osob začnete vkládat do ChatGPT promptů, je přitom zřejmé, že jste své povinnosti porušili.

Je důležité si uvědomit, že samotné vkládání osobních údajů třetích osob do ChatGPT představuje porušení Nařízení GDPR, včetně základních zásad zpracování osobních údajů zakotvených v čl. 5 Nařízení GDPR. Důvodů je celá řada:

OpenAI sama varuje uživatele před vkládáním jakýchkoliv citlivých informací nebo osobních údajů. Pokud ovšem v Podmínkách užití a v Privacy policy uvádí, že vstupy může užít ke zlepšení služeb, v zásadě by to znamenalo, že je sama správcem osobních údajů. V tomto ohledu nesplňuje informační povinnost v rozsahu požadovaném Nařízením GDPR. Už sama informace „využíváme osobní údaje ke zlepšení služeb“ je zcela neurčitá a v rozporu se zásadou účelového omezení.

- Možný neoprávněný zásah do autorských práv

Výstupy ChatGPT můžete užívat bez omezení, včetně komerčního využití. OpenAI vám k tomu dává oprávnění, ovšem za podmínky, že nebudete tvrdit, že výstup je vaším původním autorským dílem.

Existuje také riziko neoprávněného zásahu do autorských práv, který může vzniknout v důsledku toho, že bylo v rámci tréninku ChatGPT neoprávněně užito nějaké autorské dílo. A to navzdory tomu, že podle ChatGPT jsou v rámci tréninku činěna opatření k minimalizaci takového neoprávněného zásahu. V tomto smyslu odkazuji na článek ChatGPT a autorská práva, kde je problematika autorských práv blíže rozvedena.

Nežádoucí mohou být také následky využití ChatGPT v rámci programování, také ty jsou zmíněny ve shora zmíněném článku.

- Možné porušení pracovní kázně

Hodně se mluví o tom, jak se změní práce lidí v „kreativních oborech“, jejichž pracovní náplní je tvořit například reklamní texty, nabídky pro obchodní partnery, články určené ke zveřejnění apod. Druhem práce, který mají vykonávat, není sepsání několika promptů, ale tvorba konkrétního obsahu. Můžou využít ChatGPT k provádění korektur? Za splnění výše uvedených podmínek jistě ano. Ale co když si nechají veškeré „své“ výstupy vygenerovat prostřednictvím ChatGPT? Takový postup může být za určitých okolností vyhodnocen jako porušení pracovní kázně. A navíc je takové použití výstupu v rozporu s Podmínkami užití, viz bod 3 shora.

Jak používat ChatGPT správně?

ChatGPT je skvělý nástroj a určitě není správnou cestou jej preventivně zakázat nebo ignorovat. Na druhou stranu, ani neřízené a chaotické užívání není řešením. Jak tedy postupovat?

- Analýza rizik:

Na počátku je důležité vyhodnotit, s k jakým datům mají zaměstnanci přístup a jaká rizika v souvislosti s užíváním ChatGPT hrozí. Vhodné je také případně posoudit stupeň závažnosti zjištěných rizik v závislosti na dopad, který mohou mít na vaši firmu. Analýza rizik by měla obsahovat také opatření na snížení rizik a stanovit režim jejich kontroly. Inspirovat se můžete např. vyhláškou č. 82/2018 Sb., o kybernetické bezpečnosti, byť pro účely užívání ChatGPT a podobných nástrojů jsou dostatečné zpravidla i mnohem jednodušší postupy a dokumenty.

- Vnitřní předpis nebo směrnice

Máte-li už nyní vnitřní předpis k ochraně dat, osobních údajů a obchodního tajemství, stačí jej rozšířit. Pokud jej dosud nemáte, je určitě vhodné takový vnitřní předpis připravit, pokud u vás dochází ke zpracování osobních údajů nebo nakládáte s důvěrnými informacemi.

Vnitřní předpis by měl obsahovat zejména:

- Účel vnitřního předpisu.

- Srozumitelnou definici pojmů, jako jsou osobní údaj či obchodní tajemství, a také klasifikaci dat a osobních údajů.

- Povinnosti v souvislosti s klasifikovanými daty, checklisty určené k posouzení jednotlivých situací (mohu/nemohu použít ChatGPT; jsem povinen ověřit, zda nemám v promptu data o XXXXX).

- Postup zaměstnance v případě, kdy došlo k bezpečnostnímu incidentu.

- Následky a možné sankce při porušení povinností stanovených ve vnitřním předpisu.

- Prokazatelné seznámení s vnitřním předpisem, školení

Zaměstnanci jsou povinni dodržovat právní předpisy a pracovní řád. Oproti tomu ostatní vnitřní předpisy jsou podle judikatury zaměstnanci povinni dodržovat pouze tehdy, pokud s nimi byli řádně seznámeni. Pouhé přečtení nebo možnost se s ním seznámit nestačí. Zejména u složitějších předpisů je nezbytné zaměstnancům vysvětlit účel a obsah vnitřního předpisu tak, aby mu porozuměli, ideálně formou školení.

Naše advokátní kancelář má řadu zkušeností se zaváděním zmíněných postupů v souvislosti s GDPR a v současné době již aplikujeme vlastní vnitřní předpis i na užívání AI. Rádi s tím pomůžeme i vám.

Petr Otevřel | otevrel@lawyer.cz | LinkedIn

Petr je společníkem advokátní kanceláře Jansa, Mokrý, Otevřel & partneři s.r.o. a zabývá se zejména právem informačních technologií, osobních údajů a autorským právem.